1.1. 机房管理

本章节主要内容摘自王光辉-《IC设计平台搭建》

本章节主要会介绍如何做到高可用和更高能源效率的机房建设,基础设施建设,机房如何规划、建设、运维、扩充、功能、费用评估。

在当前云计算流行的情况下,对于中小公司,会面临一个决策,是否上云、如何上云。 是否上云,需要考虑很多方面,包括成本、便利性、安全、效率等。

1.1.1. 机房现状

目前机房主要有三种选择: 自建机房、Hosting托管机房、云计算中心。

首先,介绍一下传统的自建机房。大部分小公司,都是自建的一个简单机房,一般都跟 办公室在一起,独立房间,普通空调,这样的好处是快捷,成本低,缺点是标准低,容易故 障,难扩充。

其次,我们还可以选择Hosting托管。优点是:自己不需要去管机房的基础设施,基础设施等级一般都有 T3。缺点是:设备上架不方便,基础设施由别人管理,安全性存疑,可能需要提前租用下来空置,可扩展性不足,机房到办公室要有单独的网络连接。

云计算中心优点:按需扩展,不需要自己管理基础设施。缺点:服务器和存储都是云计算商的,安全存疑,从公司访问云计算中心,要通过公共网络,带宽要满足。如果是长期高性能计算,成本将比自建和 Hosting 都要昂贵很多,适合短期突发需求和计算任务较少的初创公司。

1.1.2. 自建机房

机房包含场地选择、布局、供电、消防、制冷,布线等多方面。 场地要注意不要有水淹的可能,夏天的洪水,冬天的雨雪,楼道的消防管道漏水,环境 温度隔离,冬天防冻,夏天防晒。

几个小故事:

a.某家公司,机房位于 3 楼,不靠窗,有防静电地板架空,采用的空调不是精密空调,但 是也是商用级别了,总体条件还算不错。但是,某天早上进入机房的时候,看到满地的水, 静电地板下更是积水严重。水从何而来?空调冷凝水泄露!

b.第二个故事,B 公司,机房在写字楼边上,南面就是玻璃幕墙,冬天还好,夏天阳光直 射,太热了,不得不把靠近办公室一侧的门打开散热,顺便让办公室的冷气能冷却一下机房 服务器。但是,噪音很大,办公室的人很难受。

c.第三个故事,C 公司,机房位于一楼,地库在楼下。承重是问题,不得不在机房地面放 置钢板加固。当然,还担心夏天暴雨,导致机房被外面的积水倒灌。这家公司的机房算是比 较标准的,有精密空调,有 24*7 监控,遇到问题随时自动报警,运维人员马上收到电话通 知。但是,没有双路接入,也没有发电机,UPS 能支持 30 分钟。在遇到停电故障的时候, 不得不把计算服务器关机,保障其他重要的服务器能坚持更久。

d.第四个故事,D 公司,机房两边靠玻璃墙,家用空调制冷。发生过夏天最热的时候,空 调压缩机故障,打开门不行,外面都是 38 度,不打开也不行,空调制冷量不够,机房达到 40 多度。最后,不得不搞几个电风扇,把办公室空调的冷风吹进机房来降温。

e.最后一个故事,E 公司,机房自己重新设计。承重足够,没有地下室,适当抬高,有积 水会优先排到旁边的小河。双路供电,保证不会全部停机。六氟丙烷消防,不会损害服务器。 但是,有年冬天,天寒地冻,四楼靠近窗边的消防管突然爆裂,消防水几分钟内沿楼梯一路 流到了一楼,在二楼的承重柱跟楼板的缝隙进入了机房。万幸,水不多,并且是白天,有人值守,发现及时。

1.1.3. 托管机房

Hosting 机房,只是租用供应商的空间,比如常见的电信、联通的托管服务。自己要负 责的是网络和服务器,对方提供其他配套。一般需要自己购买服务器,安装,上架。机柜可 以上锁,由自己负责维护,也可以采用金属网隔离的方式,将自己的机柜区域单独隔离出来, 非授权,其他人无法进入。机房供应商,只负责基础的设施运维。

Hosting 机房,用户不需要自建机房,直接租用即可。每个机柜每年的费用可能在 8 万 -15 万之间(要看机柜功率和用电量)。

但是,Hosting 的缺点也是存在的,比如扩充机柜的时候,发现旁边的机柜都已经被租用出去了,自己已经无法继续租用,或者只能一次性租用很多机柜。

优点:

a.节约成本 如果企业选择自行建设机房,维护机房,面临各项专业人员缺失等问题,并需要投入资金购置软硬件、支付维护和通信费用。但选择服务器托管只需支付托管费用,便可享受机房完善服务。

b.电力持续不间断选择服务器托管,机房电力 24 小时不间断,并配备后备电源,包括电池和发电机后备电源,遇上突然停电,也不会因为电力间断导致资料丢失。这一点,自建机房很难做到,特别是后备电源发电机,几乎所有的办公楼都不会允许。

c.降低辐射、减少噪音,服务器产生的噪音较大,在办公楼建设服务器机房,即使做好降噪处理,也会很大的噪音。

d.专人24小时值守服务器托管,当服务器出现故障或机房故障时,机房配备的专业 24小时技术维护人员,会在第一时间处理故障,保证安全。

e.稳定、安全 选择独立主机托管不会因为机房负载过重,造成服务器性能自动下降和瘫痪。用户可自主设置主机权限,自由选择防火墙和防病毒设施,自行选择网络带宽与网络资源。

f.更多供应商选择 IDC 机房为客户提供完善的电力、监控、空调等设备保证企业服务器的正常运转,灵活性较高,用户可根据需要选择数据中心、线路、带宽、端口以及增值服务。同时可根据实际需要灵活配置服务器。由于有多个 Hosting 托管供应商,你可以对比出最适合自己的机房。

缺点:

a.需要考虑供应商选择。可能选择机房供应商的时候,要考虑好接入网络供应商。目前国内电信机房,联通线路很难进入,反之亦然。而第三方机房,倒是可以多个供应商,但是也存在其他问题,比如网络费用较贵,地理位置不理想,离公司很远等。

b.进出设备不方便。机房一般会考虑安全,对进出设备进行严格的流程限制。在遇到紧急情况,需要上线新设备的时候,可能托管方的配合没那么及时。

c.合同周期遇到意外能不能立即停用?一般租用将都是按年核算费用,很难一次性规划好,不得不存在一些资源的浪费。如果规划过多,机房空闲,如果规划太少,机房空间不足的时候无法扩容。

d.选择的托管供应商是否稳定,机房品质参差不齐 目前有很多第三方公司,自建机房,托管服务,低价禁止,很容易出现破产或者转让给机房托管的设备带来很大风险。一定要选择资质更高机房等级较高的供应商。

e.电信、联通机房功率普遍偏小 目前电信和联通的租用机房,功耗往往比较低,一般是 4KW-5KW。一个机柜可放服务器比较少。

f.服务器的购置费用这点是相对云计算来说的,购买独立服务器的费用较贵。对比自建机房,成本完全一样。

1.1.4. 机房布局

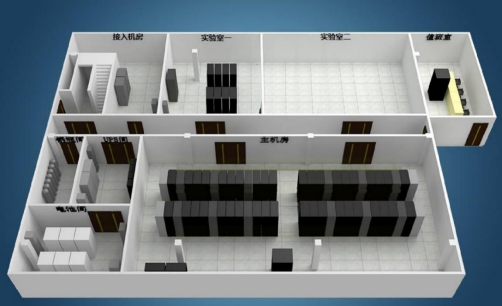

一般中小公司自建机房的时候,没有特别专业化的机房建设团队。那么,我们如何规划 一个更加合理的机房呢?我以一个 500 台服务器的机房为例。首先,我们看看布局。机房, 不只是有放服务器的地方,还有其他配套,比如有跟电信部门的接入弱电间,消防气瓶间, UPS 和电池间,接入电源的强电间,还有监控室,有类似加速器和配套服务器的实验室机房, 还有工程师单板调试的房间。

以上结构图是一个 500 台服务器规模的实际规划。我们可以看到这个数据中心分了多 个不同的功能区域:接入机房(电信接入,包括语音电话,互联网,专线接入等),实验室 机房,实验室办公区,消防钢瓶间,UPS 配电间,电池间,主机房,值班监控室。

1.1.5. 机房供电

建设机房的首要任务是计算出你到底需要多少功率的负荷,然后对接入电源跟供电方核 对,是否有满足需求的电力接入。特别是在传统办公区改造机房,一定要询问业主方/物业 方,园区的电力供应情况。然后确定 UPS 容量,最后通过设备的断电后备时间要求,计算出需要多少电池才能满足。供电系统是一个很复杂的设计,需要机房设计方认真核对,一旦错误,后期很难补救。作为用户,我们需要提供的信息主要有:总机房设备的最大负载、供电冗余要求、每机柜多少KW,电池的后备时间等。如果有条件上两路进电,一定要上,这样可以避免每年固定的电力检修要求对机房造成的停电影响。

1.1.6. 制冷

目前机房空调制冷主要有两种类型:一种是大型的精密空调,通过上送风或者下送风的 方式,在机房的地板形成冷热回路。这种方式,在很多地方使用,优点是集中送风,运维方 便。缺点是噪音很大,空调的冷热路径长,能耗损失多。

另外一种,就是行间空调。顾名思义,就是空调位于机柜旁边,空调出来的冷风,直接被空调旁边机柜内的服务器吸入然后从服务器后端排出热风,形成循环。

水冷还是风冷?这是一个难以取舍的选择。整体来说,风冷技术成熟,能耗要比水冷高。但是,水冷也有一定风险,因为管路的安装和维护,要求比较高,一旦漏水,对机房来说就是大事故,但是水冷可以降低能耗,值得考虑。水冷的时候,建议机柜下方的水管平面以下,不要走任何电线,弱电线缆也建议走顶部。同时,中央水管不要从机柜上方走过。建议选择水冷的公司,有专门的水电工,能够定期保养维护。

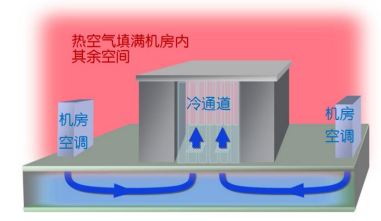

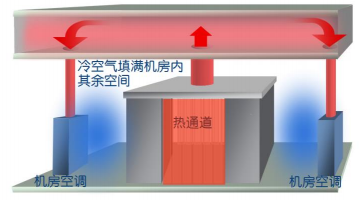

热通道还是冷通道?通道设计,是为了避免冷空气被大量浪费了,尽量将冷空气和热空气分离开。为了提升冷量的利用率以及制冷系统的能效,通常会采用密闭通道的布局方式。而这导致一个问题,机房到底是以封闭的通道为冷空气,还是封闭通道空气为热空气呢?

封闭冷通道如上图

封闭热通道如上图

从总体能效提升来看,二者相当。密闭冷通道可以避免冷量随着开关门散逸,以及减少 通过围护结构的散逸,但是密闭热通道可以通过将热量集中,使得空调更加节能省电。这还涉及到两个不同的服务器上架方式和使用方式。曾经设计过一个冷通道机房,还专门用防火玻璃设计了一个参观窗口,可惜因为内外温差,导致玻璃雾化,完全看不到机房内的情况。 冷通道,IT人员安装设备的时候,服务器进气口在通道内,安装服务器主要在封闭的冷通道内上架,一般空调在 22 度左右,人员长期在冷通道比较难受。热通道反过来,空调排出的冷空气服务器直接吸收,所以服务器要求进气口要朝外。安装服务器主要在外部空间,相对来说,因为整个机房空间比较大,外面的舒适性要好一些。

从施工角度来看,密闭冷通道必须要有架高地板,而密闭热通道必须要有回风装置,比 如风管、回风风机等。从门禁管理角度来看,密闭冷通道中机柜都是面对面的,可以实现通道级门禁和机柜级门禁,而密闭热通道中,机柜都是背对背,需要设置机柜级门禁。从运维人员舒适度来看,密闭冷通道的机房里,通道外的温度高,人员舒适度低于密闭 39 热通道的机房。

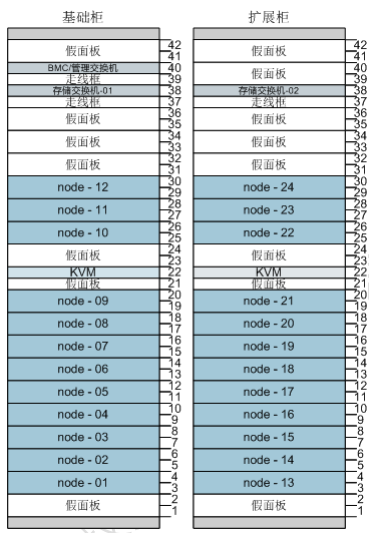

机柜及布局:需要考虑布线柜,空调柜,网络设备柜,存储设备柜,服务器柜。服务器柜的典型布局如下图,需要考虑单个机柜功耗和密度,对于空位置需要有假面板做好风道 隔离管理。

1.1.7. 布线

机房布线,经常受到环境限制。我们主要考虑的是水管布置、强电线缆布置、弱电线缆 布置。

水管包含了进出水管(水冷空调)、冷凝水的排水管。

强电线缆,主要是各设备机柜的电源供应。

弱电线缆,包括双绞线和光线线缆布局,包括机柜内和机柜外。

水管布局,要特别考虑漏水的情形,对机房的影响。机房漏水从来不是小问题,任何处 置不当,可能导致机房停止运行。

曾经遇到过一个建设方,准备把楼顶往下排水的雨水管开个口,用于排冷凝水,方便快捷。但是,如果顶楼排水管因为树叶堵塞,排不出去的时候,下雨天倒灌到机房怎么办?机房可能还有空调加湿器用于调节机房湿度,加湿器的进水管一定要设置阀门,随时可以管理。否则,遇到自来水突发高压,可能会导致进水管爆裂,从而导致机房大面积过水。

特别提醒:楼道的消防水管,一定要注意万一爆裂的情况下,如何保证这部分水不会经 过机房顶部流下去。前面讲过自己遇到的类似案例,非常危险。

强电线缆,要注意跟弱电分开走线,因为强电会干扰弱电信号。为了保证强电安全,建 议走机柜顶部。走了顶部后,注意跟弱电之间如何分离,需要做强弱电的屏蔽隔离。

弱电线缆,目前主要是部署光纤和双绞线到配线柜。

1.1.8. 环控

机房环控,主要做到几个方面:视频监控、温湿度监控,漏水检测,电话报警,PUE 显 示,机柜 PDU 功耗监控等。环控有个最核心的要考虑,机房一旦发生故障,要能第一时间 通知到相关人,所以通知的网络,不能跟现有 Internet 网络是同一套,必须是带外的,比 如通过 4G 网络,通过电话网络。

1.1.9. 空间和位置的考虑

为什么要将接入机房单独处理? 接入机房要负责跟外界沟通,包括各家运营商的接入线路:电信互联网,电信电话网络,联通的网络,专线网络等。这个地方,要经常开放给运营商的维护人员,办公的一些交换设备也需要放在这个机房。比如外网防火墙、门禁系统、OA 服务器,这个接入机房类似一般的小公司机房。

接入机房要考虑独立的 UPS 和空调。

主机房采用标准模式,设计独立的消防管网,气体灭火,UPS配电间和电池间独立。 UPS 设备目前有很多模块化可以考虑,避免机房设备不足的时候,UPS 浪费电力,可以按需关闭独立的 UPS 模块。

机房位置的选择? 这个涉及很多方面,如果建筑一开始没为机房设计,后期改造需要考虑更多。涉及到建筑结构的改变,还需要建筑设计院去重新审视,加固。我们需要考虑楼层的承重,如果我们建设机房的地方,楼下是空的,比如 2 楼以上或者有地下室,那么就需要建筑设计单位拿出承重设计数据,不能满足的时候,需要加固。一般情况下,都是不能满足的,因为建筑设计院对普通办公楼的设计承重很难达到机房要求,除非是厂房设计。一般建筑设计承重为 250kg-500kg/平方,而我们机房一般要求 1000kg-2000kg/平方。特别是 UPS电池间,这个地方的承重要求非常高。如果我们选择一楼做机房呢?不需要重新加固建筑承重,但是一楼面临其他问题,比如空调外机放哪儿?现在的建筑,一般空调外机都要求放顶楼,如果一楼机房到楼顶距离过长,会影响制冷效果,能耗损失更多。一楼还需要防水,特别是夏天暴雨的时候,地势低洼,很可能导致倒灌,一旦洪水进入机房,整个机房都要停止工作。机房的位置选择非常难,请一定要提前规划,不可将就。

1.1.10. 消防

机房的消防,目前主要采用七氟丙烷气体消防。但是消防需要地方消防部门审批方案和 备案,必须要在当地有资质的建设方才能施工。另外,消防气体释放,最好能有监控室的人 工确认,否则可能导致机房人员没有及时撤离,气体释放导致人员窒息而死的情况发生。 消防是一个更加专业和小众的方面,应该交给专业的人去处理。